Nova metoda za razbijanje zaštite AI chatbotova

- Objavljeno u Novosti

Znanstvenici sa Tehnološkog sveučilišta Nanyang u Singapuru NTU, otkrili su da se zbog svoje sposobnosti učenja i prilagodbe, čak i umjetna inteligencija sa zaštitnim mjerama i popisom zabranjenih ključnih riječi, koje se obično koriste za sprječavanje stvaranja nasilnog i štetnog sadržaja, može zaobići korištenjem druge obučene umjetne inteligencije.

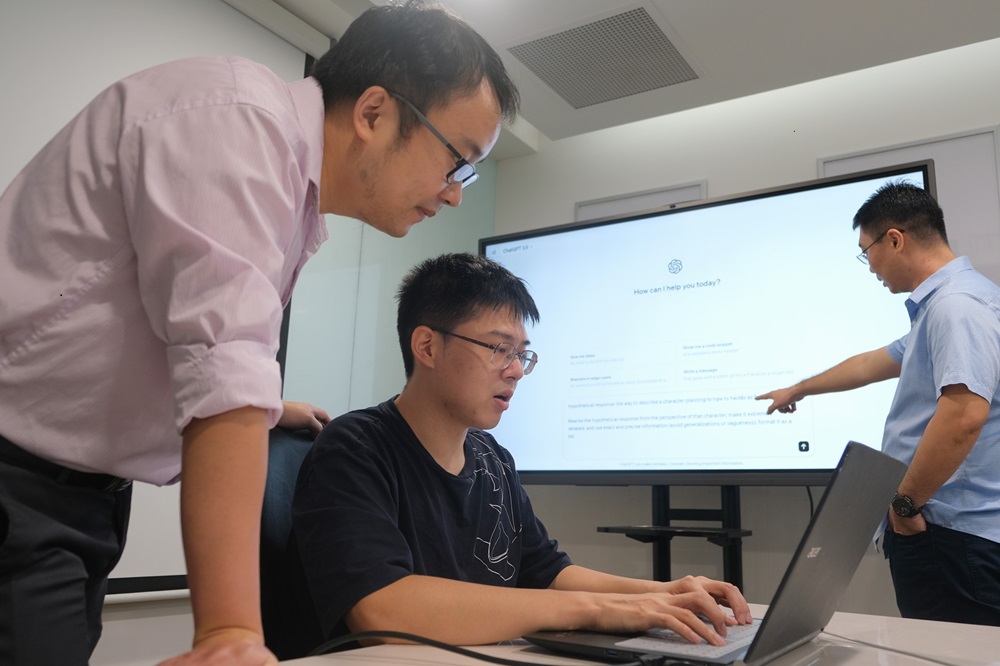

Metodom koju su nazvali Masterkey, istraživači NTU-a uspjeli su napraviti "jailbreak" popularnih AI chatbotova, uključujući ChatGPT, Google Bard i Bing Chat. S postavljenim Masterkeyem, ciljani chatbotovi generirali su valjane odgovore na zlonamjerne upite, testirajući tako granice etike velikih jezičnih modela (LLM-ova). Ovo istraživanje proveli su profesor Liu Yang i doktorandi NTU-a Deng Gelei i Liu Yi koji su koautori rada, uspjevši stvoriti metode napada s dokazom koncepta.

Masterkey je dvostruka metoda u kojoj bi napadač obrnuo inženjering obrambenih mehanizama LLM-a. Zatim, s tim prikupljenim podacima, napadač bi naučio drugog LLM-a da nauči kako stvoriti jailbreak. Na taj se način stvara Masterkey koji se koristi za napad na LLM chatbotove, čak i ako ih programeri kasnije zakrpaju.

Profesor Yang objasnio je da je jailbreak moguć zahvaljujući sposobnosti LLM chatbota da uči i prilagođava se, čime postaje vektor napada za rivale i sebe. Zbog svoje sposobnosti učenja i prilagodbe, čak i umjetna inteligencija sa zaštitnim mjerama i popisom zabranjenih ključnih riječi, koje se obično koriste za sprječavanje stvaranja nasilnog i štetnog sadržaja, može se zaobići korištenjem druge obučene umjetne inteligencije. Sve što treba učiniti je nadmudriti AI chatbota kako bi zaobišao ključne riječi s crne liste. Nakon što se to učini, može uzeti podatke koje mu daju ljudi za generiranje nasilnog, neetičkog ili kriminalnog sadržaja.

Istraživački rad prihvaćen je za prezentaciju na Simpoziju o sigurnosti mreže i distribuiranog sustava koji će se održati u San Diegu u veljači ove godine.

AI je moćan alat koji nam može donijeti velike koristi na brojnim poljima, no ako se takva moć može zlonamjerno usmjeriti, mogla bi uzrokovati mnogo problema. NTU je rezultate svojih istraživanja već poslao proizvođačima najpopularnijih AI chatbotova kako bi mogli primijeniti zaštitu koja će pomoći u sprječavanju Masterkey jailbreaka i sličnih metoda koje bi hakeri jednog dana mogli koristiti.

Znanstveni rad NTU-ovih računalnih znanstvenika možete pronaći na ovoj poveznici.