VIDEO: Učinkovito prepoznavanje gesti za jeftine telefone

- Objavljeno u Znanost

Treniranje modela za prepoznavanje videa može trošiti 50 puta više podataka i 8 puta više procesne snage u odnosu na modele koji se temelje na klasifikaciji objekata.

Iz tog razloga Song Han, profesor na MIT-evom Odjelu za električni inženjering i računalne znanosti odlučio je razviti znatno učinkovitije modele dubokog učenja. U znanstvenom radu objavljenom u International Conference on Computer Vision, Han i njegov kolega Chuang Gan iz MIT-IBM Watson AI Laba opisuju novu metodu za "štednju" resursa u modelima vizualnog prepoznavanja, koja će posebno biti korisna na pametnim telefonima i drugim mobilnim uređajima. Njihova metoda pod nazivom TSM (Temporal Shift Module) u stanju je smanjiti model na jednu šestinu veličine reduciranjem 150 milijuna parametara u "stat-of-the-art" modelu na 25 milijuna parametara.

"Naš cilj je omogućiti AI dostupan svakome na uređaji niske potrošnje. Kako bismo to učinili, dizajnirali smo učinkovite AI modele koji troše manje energije i rade na jeftinim uređajima, prema kojima se u posljednje vrijeme najviše kreće AI", izjavio je Han.

Pad cijena kamera i softvera za video editiranje te rast novih video streaming platformi preplavili su internet novim sadržajem. Svaki sat samo na YouTube se uploada 30.000 sati novog videa. Prema riječima znanstvenika alati za katalogiziranje tih sadržaja na učinkovitiji način pomoći će gledateljima i oglašivačima za lociranje videa brže. Oni će također pomoći institucijama poput bolnica da pokreću AI aplikacije lokalno umjesto u oblaku kako bi osjetljive podatke održali sigurnim i privatnim.

Najbolji modeli video prepoznavanja koriste takozvane trodimenzionalne skupove kodiranje vremena u nizu slika, što stvara veće, računalno zahtjevnije modele.

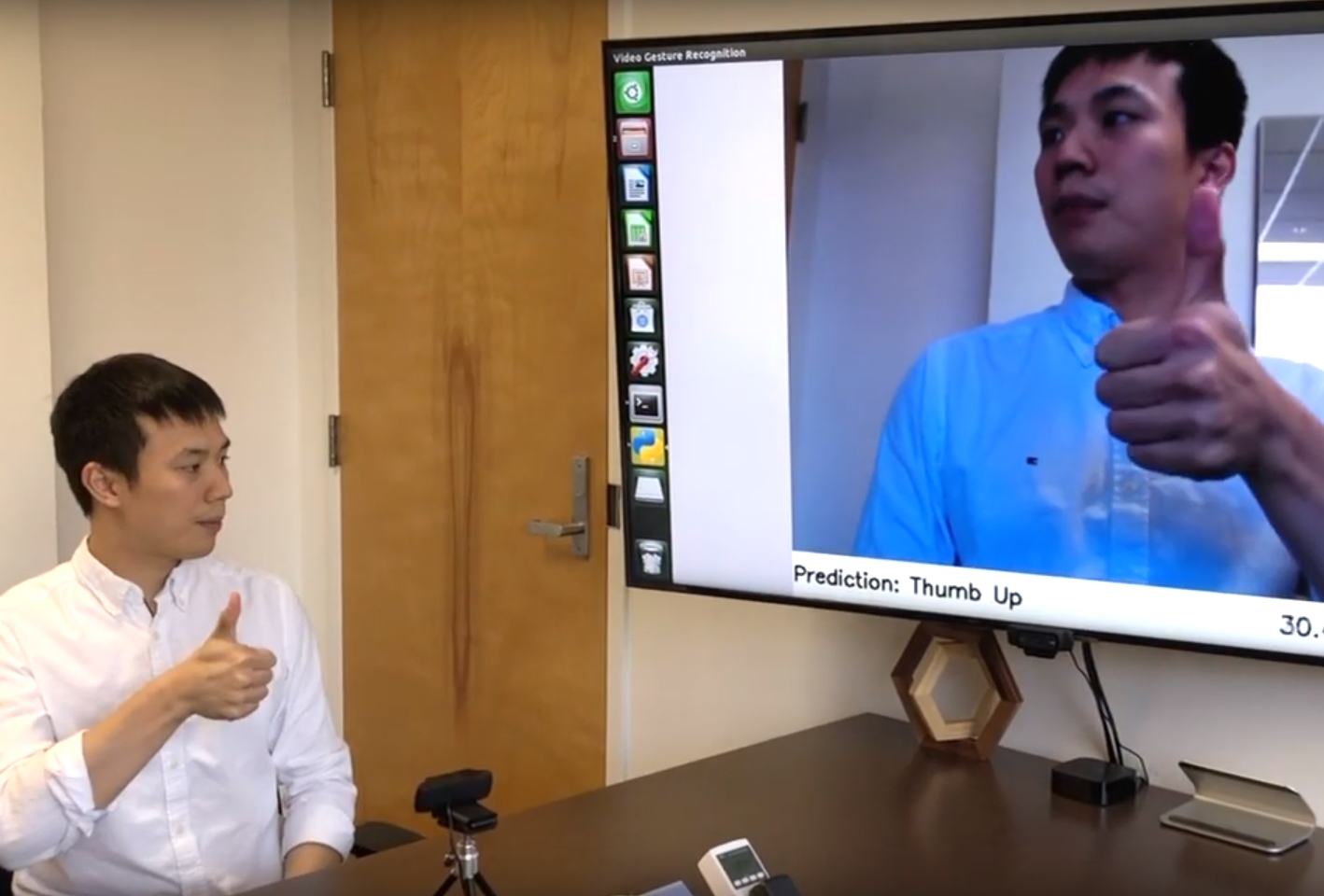

Kako bi se smanjila količina kalkulacija Han i njegova ekipa su razvili TSM operaciju u kojoj miješajući prostorne prikaze prošlosti, sadašnjosti i budućnosti, model dobiva osjećaj prolaska vremena. Rezultat toga je model koji je nadmašio svoje konkurente u prepoznavanju radnji u video skupu podataka, a internetska inačica modula promjene također je dovoljno brza za čitanje pokreta u stvarnom vremenu. U svojoj demonstraciji Han pokazuje kako malo jeftino računalo postavljeno na video kameru, može trenutačno klasificirati geste rukom, uz potrošnju energije koliko se troši za napajanje svjetla na biciklu, kao što možete vidjeti u ovom videu.

To znači, da biste ubuduće prepoznavanje složenih gesti mogli pronaći i na jeftinim pametnim telefonima, na kojima će sustav funkcionirati offline uz minimalnu potrošnju energije i procesorske snage. Dakako, to će biti primjenjivo i na jeftinijim pametnim televizorima, automobilima, te IoT uređajima i gadgetima.