Rasuđivanje velikih jezičnih modela se precjenjuje

- Objavljeno u Znanost

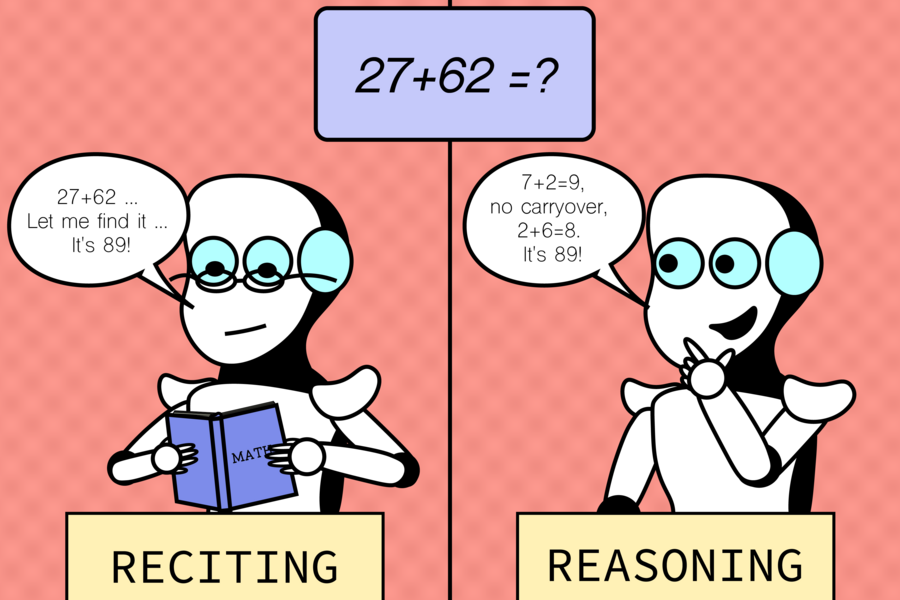

Veliki jezični modeli umjetne inteligencije ili LLM-ovi lako odgovaraju na naša pitanja temeljem otkrivanja podataka iz baza i sposobnosti "pamćenja", no u različitim varijacijama istih zadataka često griješe jer nemaju osnovne vještine zaključivanja poput ljudi.

Istraživači Laboratorija za računalnu znanost i umjetnu inteligenciju (CSAIL) na Institutu tehnologije u Massachusettsu (MIT) ispitali su kako LLM-ovi prolaze s varijacijama različitih zadataka, otkrivajući intrigantne uvide u razliku između vještina pamćenja i zaključivanja, otkrivši da su njihove sposobnosti rasuđivanja često precijenjene.

Studija je uspoređivala uobičajene zadatke na kojima se model obučava i testira, s "kontračinjeničnim scenarijima", hipotetskim situacijama koje odstupaju od zadanih uvjeta, s kojima se obično može očekivati da će se nositi modeli poput GPT-a.

Istraživači su razvili neke testove prilagođavanjem postojećih zadataka umjesto stvaranja potpuno novih. Koristili su niz skupova podataka i mjerila posebno skrojenih za različite aspekte mogućnosti modela za stvari kao što su aritmetika, šah, procjena koda, odgovaranje na logička pitanja itd.

Kada korisnici komuniciraju s jezičnim modelima, svaka aritmetika obično je u bazi 10, poznatoj bazi brojeva za modele. No promatranje da im je dobro na bazi 10 moglo bi nam dati pogrešan dojam da uz to imaju i jaku kompetenciju.

Logično, ako doista posjeduju dobre vještine zbrajanja, očekivali biste pouzdano visoku izvedbu u svim bazama brojeva, slično kalkulatorima ili računalima. Istraživanje je pokazalo da ovi modeli nisu tako robusni kao što mnogi misle. Njihova visoka izvedba ograničena je na uobičajene varijante zadataka i pate od dosljednog i ozbiljnog pada izvedbe u nepoznatim protučinjeničnim scenarijima, što ukazuje na nedostatak generalizirajuće sposobnosti zbrajanja.

Uzorak je vrijedio za mnoge druge zadatke poput sviranja glazbenih akorda, prostornog rasuđivanja, pa čak i šahovskih problema u kojima su početni položaji figura neznatno izmijenjeni. Iako se od ljudskih igrača očekuje da još uvijek mogu odrediti zakonitost poteza u izmijenjenim scenarijima (uz dovoljno vremena), modeli su se mučili i nisu mogli bolje funkcionirati od nasumičnog pogađanja, što znači da imaju ograničenu sposobnost generaliziranja na nepoznate situacije. A velik dio njihove izvedbe na standardnim zadacima vjerojatno nije posljedica općih sposobnosti za obavljanje zadataka, već prekomjernog prilagođavanja ili izravnog pamćenja onoga što su vidjeli u podacima o obuci.

Usredotočenost studije na specifične zadatke i postavke nije zahvatila cijeli niz izazova s kojima bi se modeli potencijalno mogli susresti u aplikacijama u stvarnom svijetu, signalizirajući potrebu za raznolikijim okruženjima za testiranje. Budući bi rad mogao uključivati proširenje raspona zadataka i protučinjeničnih uvjeta kako bi se otkrilo više potencijalnih slabosti, to bi moglo značiti razmatranje složenijih i manje uobičajenih scenarija. Tim također želi poboljšati interpretabilnost stvaranjem metoda za bolje razumijevanje razloga koji stoje iza procesa donošenja odluka u modelima.

Ovaj rad čini važne korake u rješavanju ovog pitanja. Konstruira paket pažljivo osmišljenih protučinjeničnih procjena, pružajući nove uvide u mogućnosti najsuvremenijih LLM studija. Otkriva da je njihova sposobnost rješavanja neviđenih zadataka mnogo ograničenija nego što su mnogi očekivali. Ima potencijal potaknuti buduća istraživanja u pravcu identificiranja načina pogrešnog rada današnjih modela i razvoja boljih.

Studiju znanstvenika MIT CSAIL-a možete pronaći na ovoj poveznici.