VIDEO: Google poboljšava AI spekulativnim dekodiranjem

- Objavljeno u Novosti

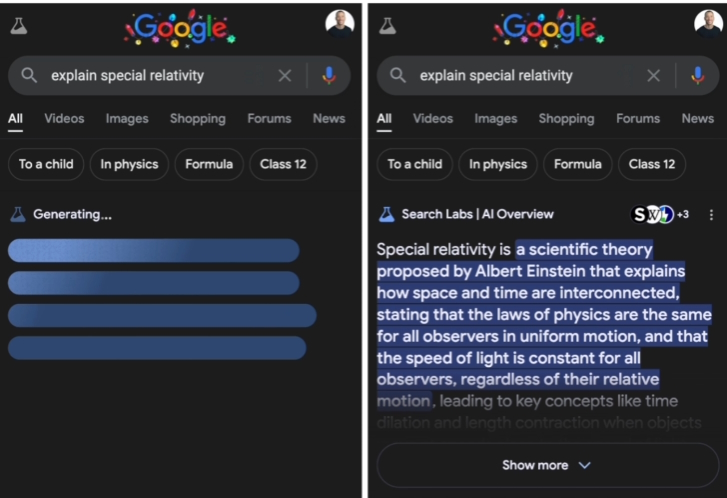

Veliki jezični modeli (LLM-ovi) u središtu su nedavnog brzog napretka u umjetnoj inteligenciji. Iako su revolucionarni, izazov za proizvode namijenjene korisniku je u tome što su ti veliki modeli zbog svoje veličine spori u zaključivanju, odnosno "generiranju izlaza", što može rezultirati neželjeno sporim korisničkim iskustvom.

Google je 2022. godine objavio "brzo zaključivanje iz transformatora putem spekulativnog dekodiranja", koje je uvelo tehniku koja se zove spekulativno dekodiranje koje može značajno smanjiti vrijeme zaključivanja za LLM.

Sada Google detaljno objašnjava kako Algoritam ubrzava generiranje iz autoregresivnih modela računajući nekoliko tokena paralelno, bez utjecaja na kvalitetu izlaza, čime ta metoda jamči identičnu distribuciju outputa.

Brža proizvodnja rezultata s istim hardverom također znači da je potrebno manje strojeva za opsluživanje iste količine prometa, što opet znači smanjenje troškova energije za opsluživanje istog modela.

Od tada je spekulativno dekodiranje primijenjeno u nizu Googleovih proizvoda, gdje donosi ubrzanja u zaključivanju, istovremeno zadržavajući istu kvalitetu odgovora, kao što možete vidjeti u ovom videu.

Ovaj inovativni pristup koji su razvili Google Research i DeepMind, koristi okvir dvostrukog modela za optimizaciju računalne učinkovitosti. Podjelom zadataka između manjeg modela nacrta i većeg ciljanog modela, spekulativno uzorkovanje postiže brzine generiranja teksta koje su u prosjeku 2-3 puta brže.